(한국어 버전은 아래에 있습니다. 👇)

As mentioned in the previous first post,

most of the IT world we currently live in is built and operated on the computer architecture worldview.

Therefore, by looking at changes in technology and products through the lens of computer architecture concepts, we can gain new insights and ideas about opportunities that were previously unobservable as consumers.

In this series of posts, I aim to discover new ideas and opportunities by reinterpreting the changes in our lives (business opportunities) we have experienced through the application of computer innovation history.

In the technology field, the term “bottleneck” is frequently used.

Like the narrow neck of a bottle, it refers to the problematic part that hinders the performance of an entire system.

Personally, I tend to explain it more intuitively as the “law of the minimum” rather than the bottleneck phenomenon. The law of the minimum states that if one essential nutrient is deficient in a plant, the plant’s growth will not be good no matter how abundant the other essential nutrients are. As a law that can be applied to organically functioning systems, it often appears in organizational operations as well.

In this IT world we currently live in, if we can understand the structure of the current IT system, and recognize how newly discovered scientific and technological innovations bring innovation to certain bottlenecks within the existing system, we can predict in advance how the overall system value will expand.

Regarding the control/memory topic, instead of past cases, let me first discuss the conclusion:

the current AI system has a bottleneck in the control/memory part.

This is also related to the von Neumann architecture mentioned in the first post.

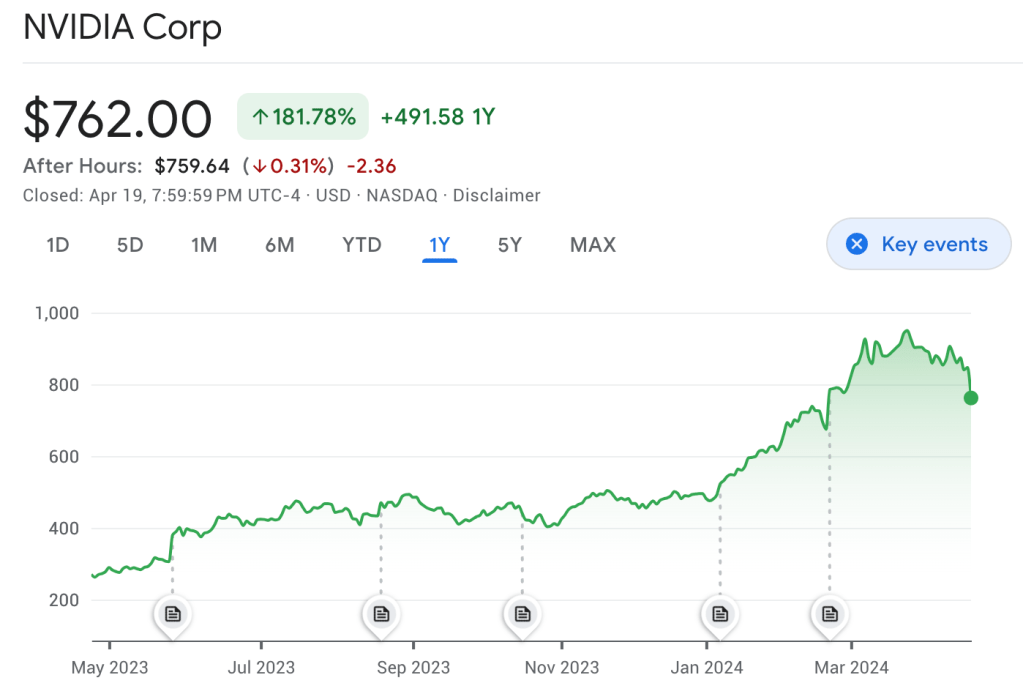

In the von Neumann architecture world, we currently live in, GPU has been considered an alternative among the available methods, which is why Nvidia’s stock price soared for a while, and all major tech companies like Google, Meta, and Amazon are developing their own AI chips to find temporary solutions. However, there is still no way to dramatically improve the actual bottleneck.

Quantum computing is often discussed as the next-generation computing to solve this, but realistically, it will take a while for applications to develop to the extent of usage we desire. Therefore, I expect innovations in memory, such as the currently popular HBM (High Bandwidth Memory), will realistically help solve the AI innovation bottleneck.

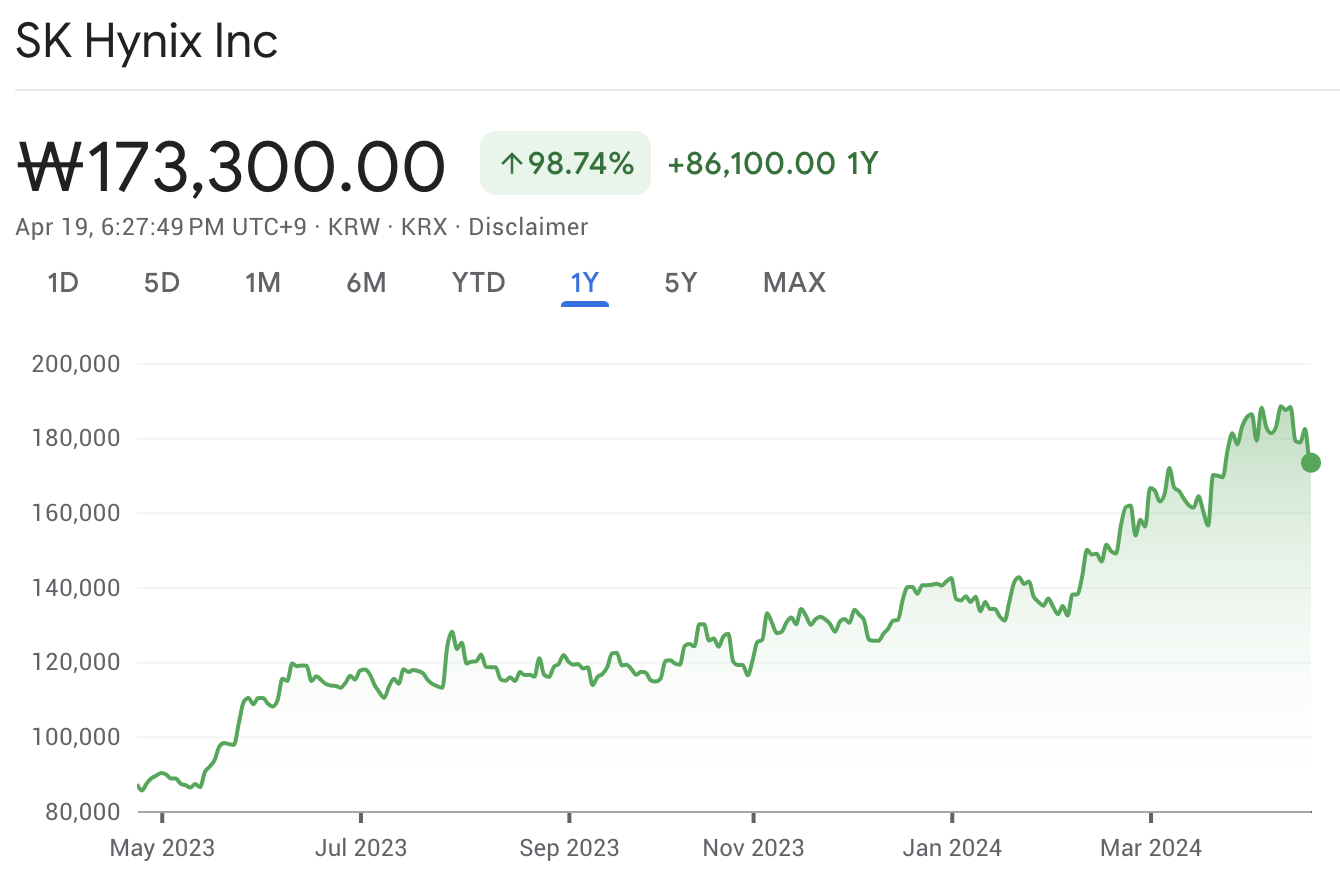

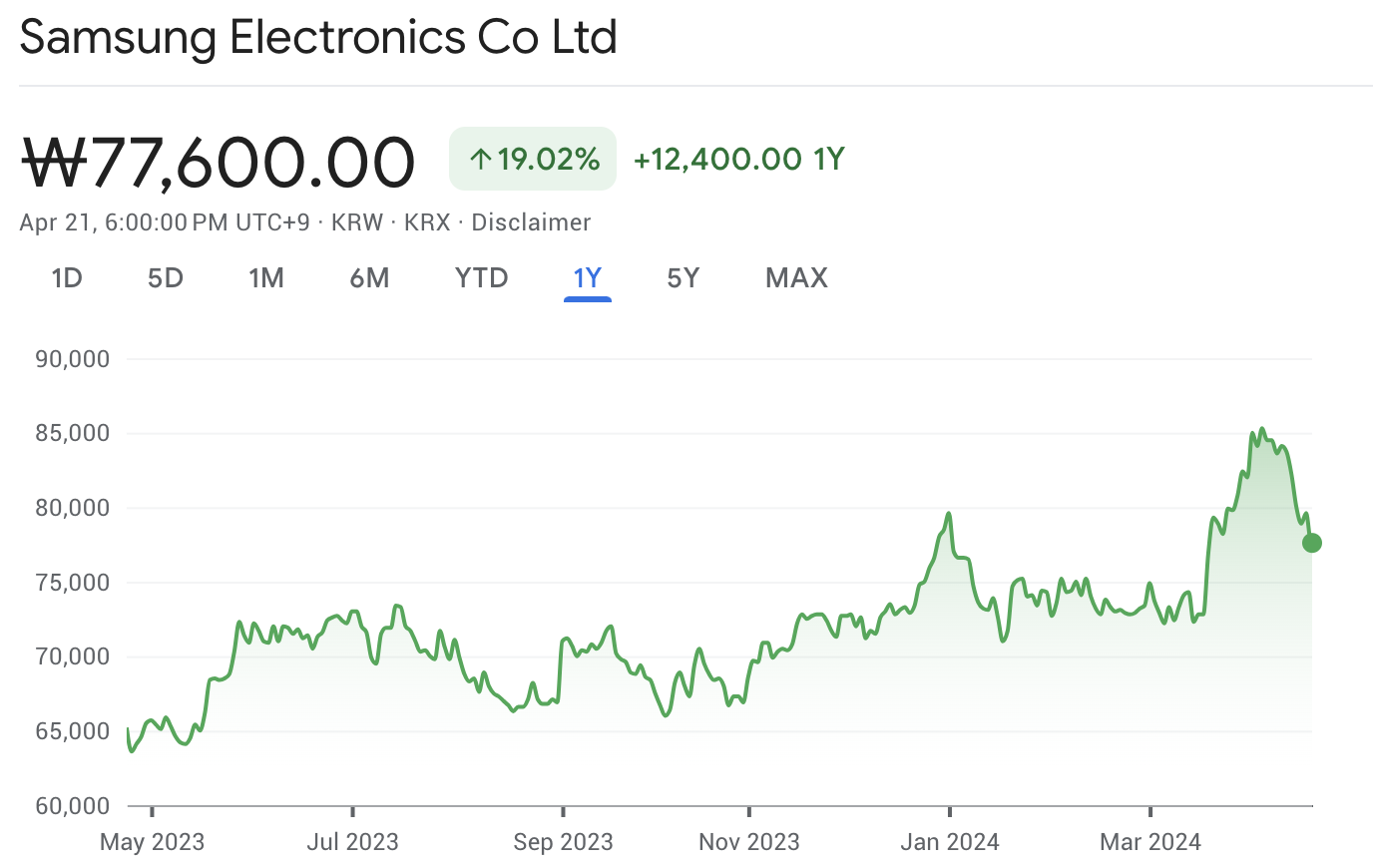

More specifically, I expect something cool later from ‘Process In Memory’ or ‘Compute In Memory‘. For this reason, I have expectations for Samsung Electronics, which has both Memory and ASIC in its business structure, for the next innovation. However, seeing their progress lagging behind Hynix in HBM development, I am actually more concerned.

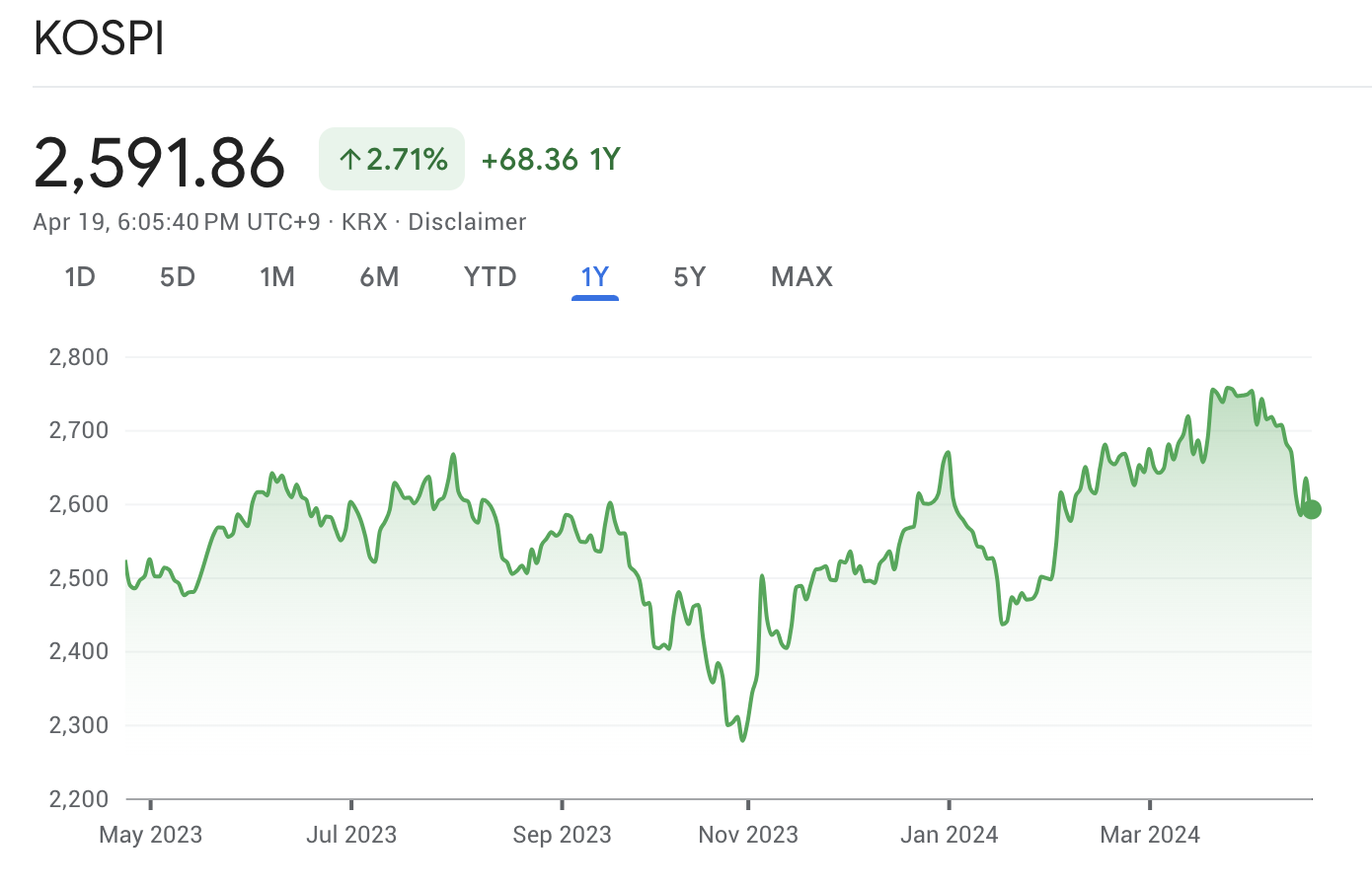

- SK Hynix stock has significantly outperformed Samsung over the past year, with a return of 98.74% compared to Samsung’s 19.02%. This impressive performance was driven by the advancement in HBM technology. Compared to the 2.71% performance of the Korean stock market index (KOSPI) during the same period, SK Hynix’s record is even more outstanding.

To reach this conclusion, it seems like I will have to tell quite a long story,

but I will try to explain them gradually as they come to mind.

Previous post 👇

지난 첫 번째 포스트에서 언급했던 것처럼, 현재 우리가 살고 있는 IT 세상의 대부분은 computer architecture worldview 위에 만들어지고 운영되고 있다. 따라서, computer architecture 컨셉으로 기술과 제품의 변화를 바라보게 되면, 그 동안 소비자로서는 관찰할 수 없었던 새로운 기회들에 대한 통찰과 아이디어를 가질 수 있게된다. 따라서, 이 포스팅 시리즈에서는 지금까지의 computer innovation history 를 적용하여 우리가 경험한 삶의 변화(사업 기회)를 새롭게 해석 해봄으로써 새로운 아이디어와 기회들을 발견해보고자 한다.

기술분야에서는 bottleneck 이라는 용어를 많이 사용한다. 병의 좁은 목 처럼, 한 시스템 전체의 성능을 발목잡는 문제적 부분을 지칭하는 의미이다. 나는 개인적으로 병목현상 보다는, 훨씬 더 직관적으로 잘 와 닿는 low of the minimum 으로 주로 설명하곤 한다. Low of the minimum 은 식물의 필수 영양소 중 한 부분이 결핍되면, 다른 필수 영양소들이 아무리 풍부하더라도 식물의 성장은 좋지 못하다는 법칙인데, 유기적으로 작용하는 시스템에 적용될 수 있는 법칙이기에 조직운영에서도 자주 등장하는 법칙이다.

우리가 현재 살고있는 이 IT 세상에서도 역시, 현재의 IT system 의 구조를 이해한 것을 바탕으로, 새롭게 발견되는 과학기술들이 기존 시스템 내에서의 어떤 bottleneck 에 혁신을 가져오는지를 파악할 수 있다면, 전체 system value 가 어떻게 확장될지 미리 예측할 수 있게 된다.

이번 control/memory 주제에 대해 과거 사례 대신 결론을 먼저 얘기해보자면,

현재의 AI 시스템은 control/memory 부분에 bottleneck 이 있다.

이것은 지난 첫번째 포스팅에서 언급한 von neumann architecture와도 연관된다.

우리가 현재 살고있는 von neumann architecture 세상에서 그나마 현재 사용 가능한 방법들 중 대안이 GPU 로 여겨지기 때문에 한동안 Nvidia의 주가가 치솟았고, 다른 임시방편들을 마련하고자 Google, Meta, Amazon 등 모든 Big tech 회사들이 자신들의 AI Chip을 개발하고 있다. 하지만, 실제 bottleneck을 획기적으로 개선하는 방법은 아직 없다.

이를 해결할 다음 세대 컴퓨팅으로 퀀텀 컴퓨팅을 많이들 이야기하지만, 현실적으로 우리가 원하는 만큼의 usage 로 application이 발전하기까지는 한참 걸릴 것이다. 때문에, 나는 현재 주목받고 있는 HBM (High Bandwidth Memory)과 같이 memory 에서의 혁신이 현실적으로 AI 혁신 bottleneck을 해결하는데 큰 도움을 줄 것이라 예상한다. 좀 더 구체적으로는 Process In Memory 또는 Compute In Memory. 이런 이유로, 비즈니스 구조상 Memory 와 Asic 을 모두 가지고 있는 삼성전자에게 next innovation 을 기대해 보지만, HBM 개발도 Hynix에 뒤쳐진 그들의 행보를 보면 사실 오히려 걱정이 앞선다.

- 작년 동안 SK Hynix 주식은 삼성보다 훨씬 우수한 성과를 거뒀다. HBM 에서의 선전으로 SK Hynix는 삼성의 19.02%에 비해 98.74%라는 놀라운 수익률을 기록했습니다. 동일 기간 동안 한국 주식 시장 지수(KOSPI)가 2.71%의 성과를 거둔것에 비교하면 SK Hynix의 기록은 더욱 돋보적이다.

이 결론까지 다다르려면 꽤 많은 이야기를 풀어내야 할 것 같지만, 떠오르는대로 차근차근히 풀어보려고 한다.

Leave a comment